La semaine dernière, Nutanix a tenu sa conférence annuelle aux USA .NEXT 2017 à Washington avec de nombreuses nouvelles fonctionnalités, outils, partenariats… L’intégralité de ces annonces sont disponibles sur la retransmission du deuxième jour de la conférence sur Youtube : lien (avancer jusqu’à 19e minute pour passer les témoignages).

AHV Turbo Mode

Face à toutes ces nouvelles, je fais un choix de placer le “AHV Turbo Mode” en premier point car il ne s’agit pas d’une nouvelle fonctionnalité mais d’une amélioration de l’hyperviseur Acropolis. De plus, l’adoption d’AHV augmente rapidement si bien que 23% des nouveaux noeuds Nutanix tournent sur Acropolis. Le Turbo Mode n’est pas un simple bouton pour aller plus vite mais bien un changement d’architecture d’Acropolis pour la gestion des I/O des VM.

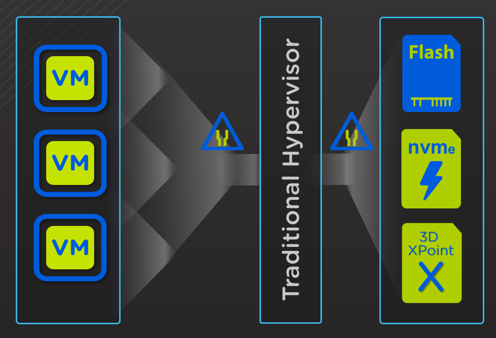

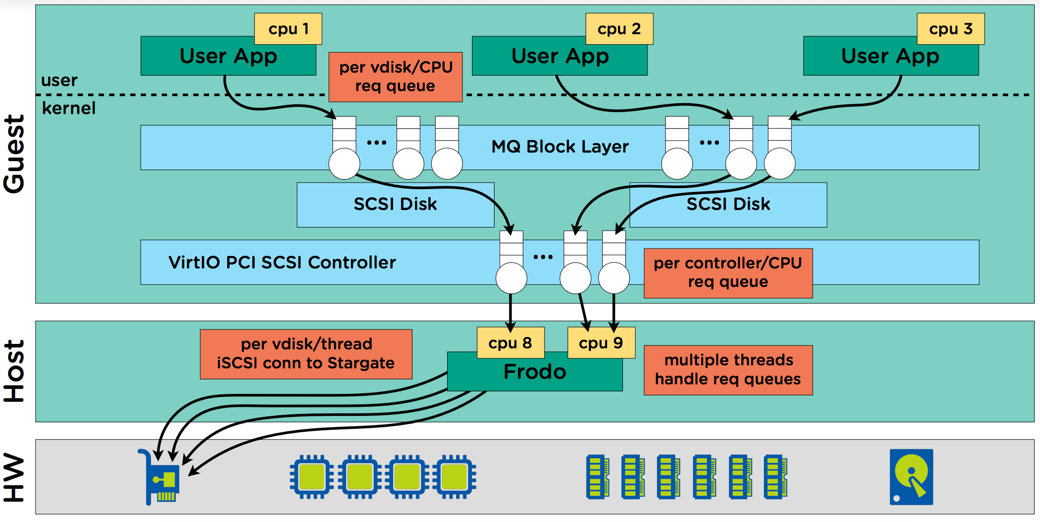

Voici le constat fait par Nutanix : La Nutanix Controller VM (ou CVM) qui contrôle le stockage de chaque noeud délivre une excellente performance quelque soit l’hyperviseur sous-jacent. Cependant, un des goulots d’étranglement principal reste l’hyperviseur lui-même et risque de devenir problématique avec l’apparition des nouvelles technologies de stockage (NVMe, 3D XPoint). AHV Turbo Mode est une optimisation du chemin de l’I/O (raccourci et élargi) entre la VM utilisateur et le stockage (Stargate).

- Principal Bottleneck

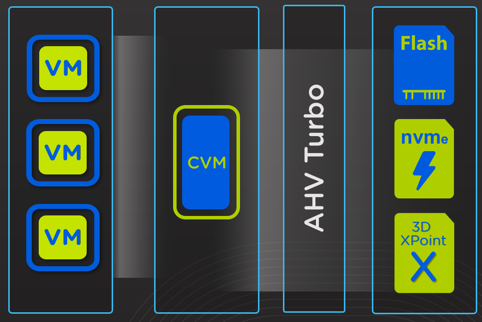

- AHV Turbo Mode

On voit dans le schéma suivant l’apparition d’un nouveau composant Frodo (a.k.a Turbo Mode), toutes les I/O de la VM utilisateur passent par celui-ci. Afin d’améliorer la performance globale en lecture et écriture, chaque vdisk de la VM dispose de sa propre “queue” http://lesfoulees43.fr/?kykywka=saint-quentin-site-de-rencontre-gratuit&cde=3f (Multi-Queue Block Layer). Auparavant, on faisait plusieurs contrôleurs PVSCSI (Paravirtual SCSI) et on répartissait les vdisks car les “queue” étaient gérées au niveau du contrôleur. Ainsi, chaque nouveau vdisk ajouté à un VM sous AHV disposera de cette amélioration sans se préoccuper de savoir sur quel contrôleur il se place. La gestion de toutes ces “queue” est gérée par plusieurs threads de Frodo et sont ensuite redirigés vers Stargate (service de gestion de l’I/O au sein de la CVM).

La particularité de Frodo est qu’il tourne au niveau du User-Space et non In-kernel de l’hyperviseur AHV. Ce point entraine une diminution de la consommation CPU et RAM tandis que les IOPS et le débit augmente, comme le montre les tests suivants (NX-3450 en Hybride) :

- 25% lower CPU usage for the similar sequential write performance (2929MBps vs 2964MBps)

- 27.5% higher sequential read performance (9512MBps vs 7207MBps)

- A 62.52% increase in random read IOPS (510121 vs 261265)

- A 33.75% increase in random write IOPS (336326 vs 239193)

N.B : L’article d’Intel suivant (et relayé par Josh) montre la différence de latence lors d’une requête de lecture via le driver NVMe dans l’espace utilisateur ou dans le noyau : lien Intel. On voit tout de suite l’importance du Turbo Mode avec l’émergence des nouvelles technologies de stockage.

Pour approfondir : AHV Turbo Mode (Article original de Josh Odgers, Solution Architect @ Nutanix)

Nutanix Xi Cloud

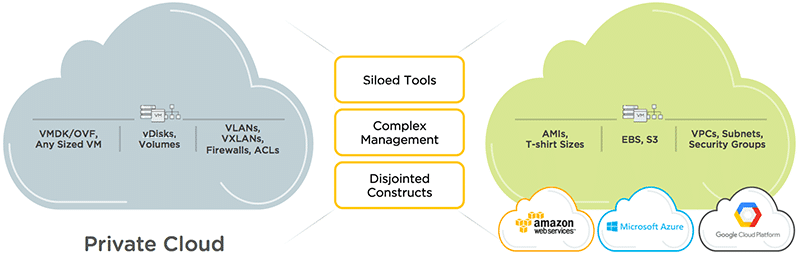

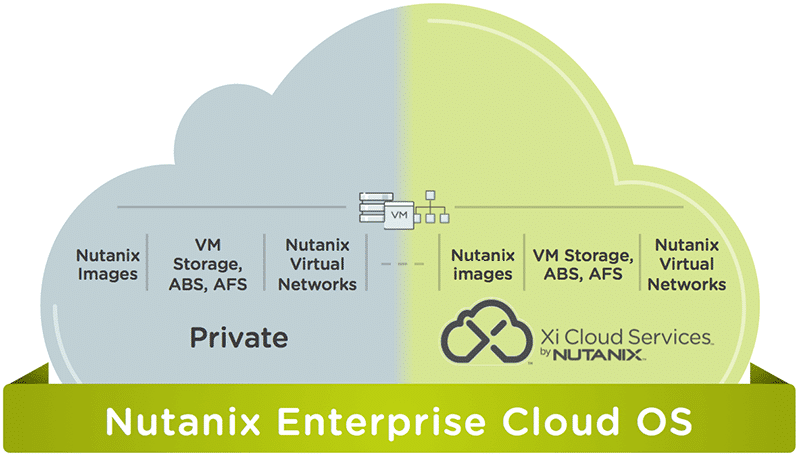

Nutanix se lance dans le Cloud Public ! Et oui, Nutanix va très prochainement déployer son propre datacenter sous Nutanix afin de simplifier l’accès au Cloud Public pour les utilisateurs de Nutanix On-Premise. Premièrement en créant deux DC aux USA (1 côte Est et l’autre côte Ouest), et ensuite s’appuyant potentiellement sur le partenariat avec Google pour propager son offre sur le monde entier.

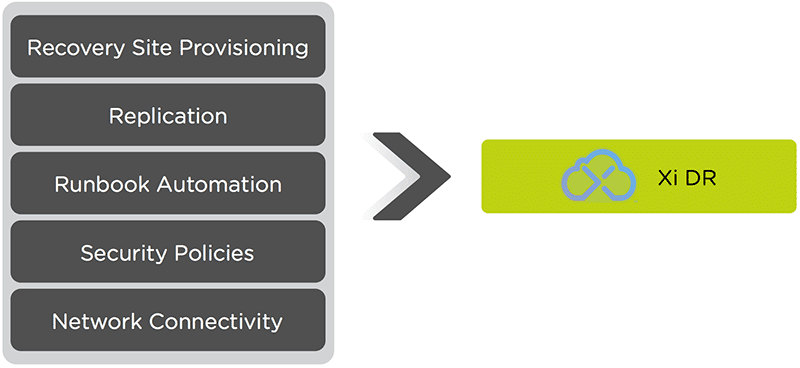

Le but est de proposer un interface intuitive via Prism Central et retrouver les mêmes fonctionnalités via un unique Nutanix OS (Nutanix Images, ABS, AFS, Nutanix networks…). La première fonctionnalité est de faire du Xi DR afin d’avoir son PRA sur le Cloud Public. De plus, il sera possible de jouer des tests de Failover et Failback avec des scénarios de recovery pour automatiser le redémarrage. Enfin, la possibilité d’étendre le réseau privé sur le Cloud pour éviter le Re-IP des VM sera également disponible.

- Complexité Private/Public Cloud

- Nutanix On-Premise / Xi Cloud

- Xi DR

- Fonctionnalités Xi Cloud

Pour approfondir : Xi Cloud (Article original de Nutanix)

Xtract

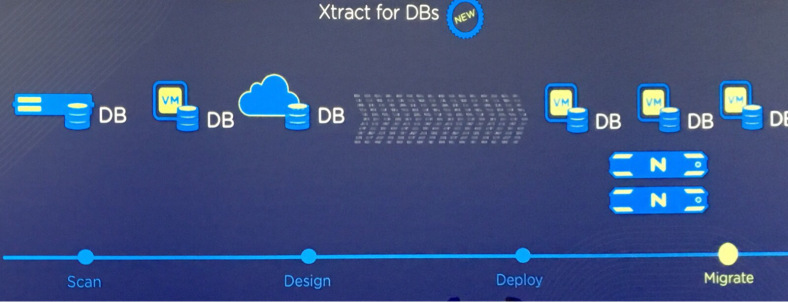

Cet outil est réservé pour la migration de workloads vers du Nutanix. Deux versions de Xtract vont voir le jour :

- Xtract for DB : Déjà GA depuis la .NEXT 2017

- Xtract for VM : En cours de développement

L’environnement Nutanix permet d’héberger des BDD SQL qui demandent de grandes performances (à la fois transactionnelles et décisionnelles). Xtract for DB facilite la migration des BDD existantes vers votre cluster Nutanix. Il découvre toutes les instances SQL de l’infrastructure, analyse leur configuration/performances et applique les best-pratices Nutanix vers la destination afin d’optimiser leur exécution.

Les BDD sont donc transformées au niveau applicatif, et permet de migrer vos bases SQL depuis n’importe quelle source (VM, physique ou même du Cloud Public). Le support de SQL server commence à partir de 2008 R2 et ultérieur.

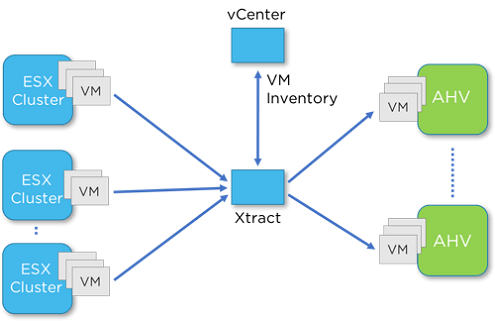

Pour la partie Xtract for VM, il faudra patienter un petit peu car elle est toujours en développement. Cet outil permettra de migrer toutes vos VM de l’environnement vSphere (même hors Nutanix) vers votre cluster Nutanix sous AHV avec un “near-zero” downtime. Comment cela fonctionne ?

- Vous allez être capable de vous connecter à votre vCenter afin de découvrir toutes les VM de l’infrastructure

- Vous créez un nouveau “Migration Plan” avec les VM à migrer

- Un credentials vous sera demandé afin d’intégrer les NGT et vous devrez mapper le réseau source et destination (possibilité de schedule automatique de la migration)

- Un premier seeding (envoi de la donnée) avec l’aide des snapshots VMware sera effectué

- Lors de la migration finale, les VM seront arrêtées et une dernière synchronisation aura lieu avant l’allumage de la VM du côté d’AHV. La VM éteinte à la source aura un message dans les commentaires vSphere pour vous dire quand est-ce qu’elle a été migrée sur AHV.

Le plus simple, c’est de regarder cette petite vidéo Youtube proposé par Nutanix pour se faire une idée 🙂

https://www.youtube.com/watch?v=fwMy0zVyvC0

X-Ray

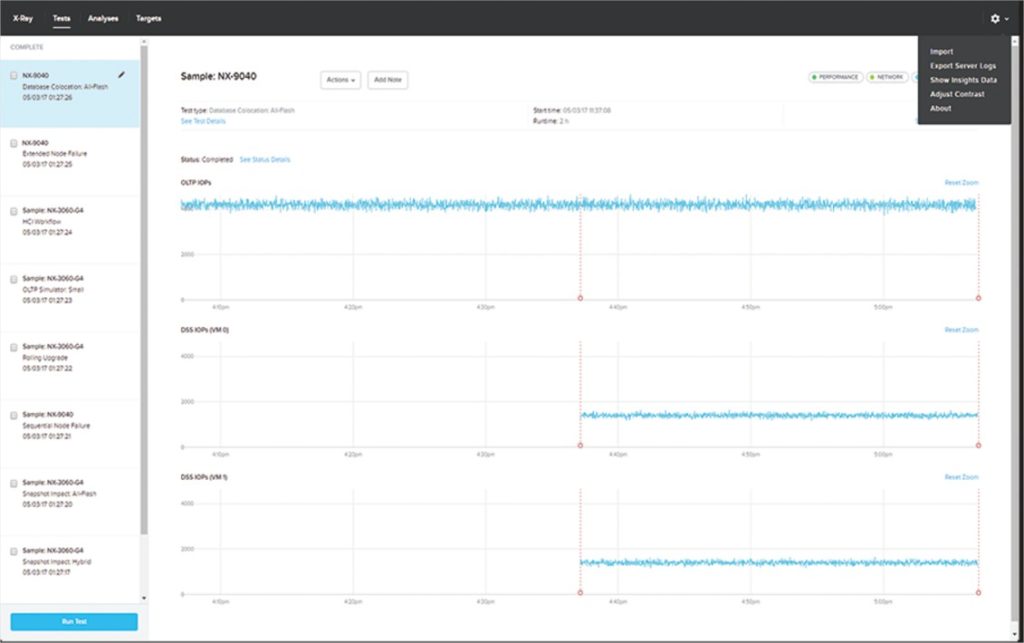

L’outil X-Ray fait l’analyse automatisée de scénarios de test sur l’infrastructure Nutanix. Ainsi, les utilisateurs de Nutanix pourront réellement tester leur système pour connaitre ses performances, sa résilience, sa fiabilité… Vous allez pouvoir réaliser des workloads sur le système tout en ajoutant des événements réalistes qui sont rencontrés dans le management de la plateforme : prises de snapshots, perte d’un noeud, éteindre un noeud, ajout de nouveaux workloads ou VM.

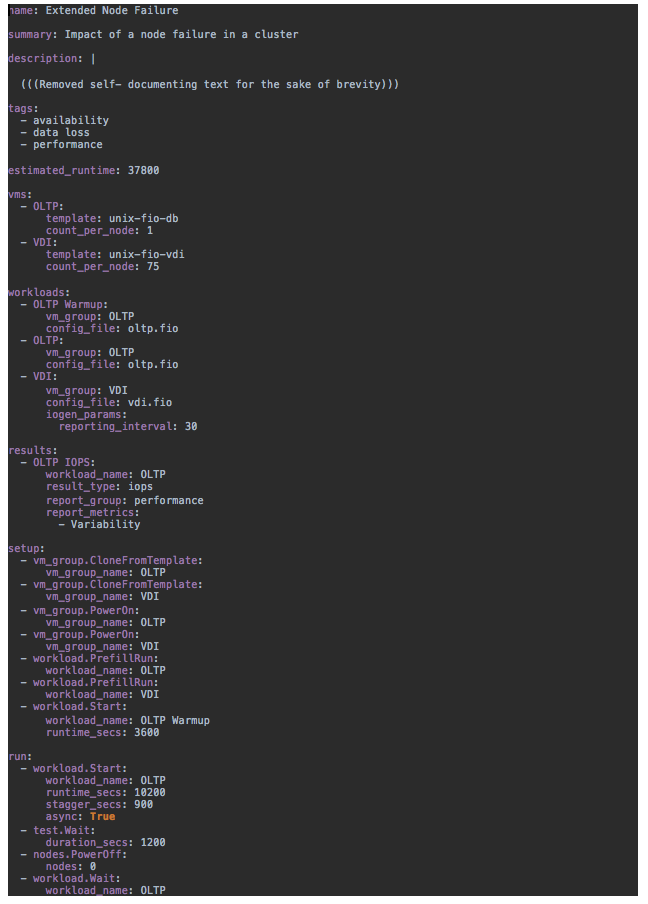

X-Ray repose sur l’outil Open-Source FIO qui permet de réaliser de nombreuses opérations. Chaque workload doit être paramétré sur FIO afin d’obtenir un fichier de configuration et de l’ajouter ensuite dans la configuration X-Ray qui est de type YALM (bout de code ci-joint).

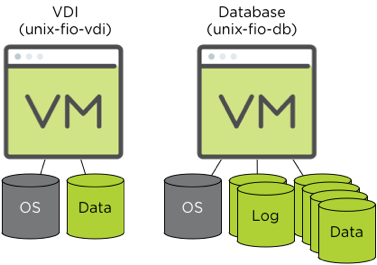

La configuration de X-Ray tient donc dans ce fichier qui définit par exemple ici un node failure et le déploiement de 75 VDI/node et 1 OLTP/node avec leur fichier de configuration FIO (attention chaque groupe de VM aura le même fichier de configuration). Actuellement, seulement 2 gold images sont packagés avec X-Ray (VM VDI et VM OLTP) :

La partie “run” du scénario permet de définir le workflow : démarrage des VM, prises des snapshots, migration des VM, arrêt de nodes etc… et de commencer la collecte des informations afin de faire le rapport.

La partie “setup” permet simplement de créer l’environnement de test avec la création de tous les clones et allumage des VM.

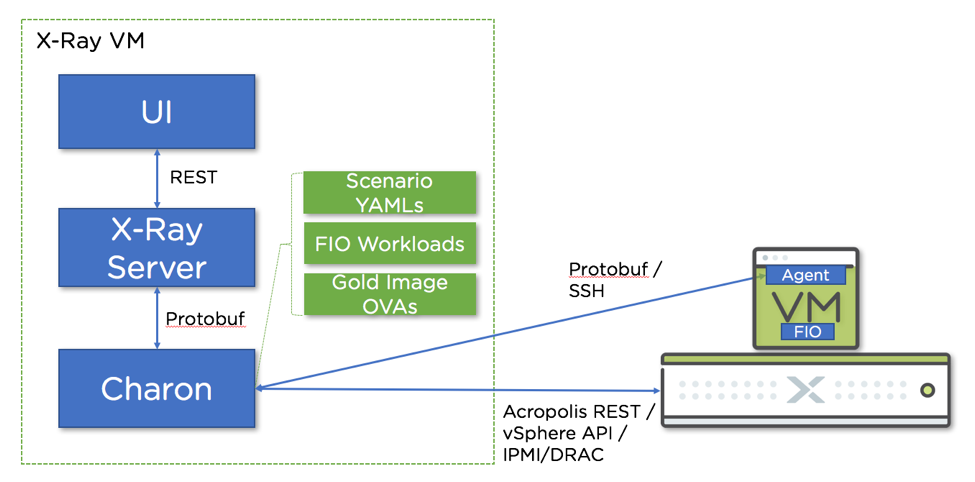

Pour la partie Architecture de X-Ray, il faut savoir que cet outil est packagé dans une VM qui contient l’outil X-Ray et les Gold images. Cette VM peut être découpée en 3 composants majeurs : 1) L’interface utilisateur, 2) le serveur X-Ray et 3) Charon.

Charon s’occupe de l’exécution de tous les tests X-Ray, il interprète les informations YALM pour construire le futur scénario (tests applicatifs et environnementaux). Il est en charge de la communication avec tous les composants de l’infrastructure destination (vCenter / Prism) afin de mener à bien tous les tests choisis. Charon est codé en python et utilise le vSphere SDK pour les destination vSphere, les Rest API pour de l’AHV et l’IPMI/DRAC pour les événements sur les nodes. De plus, chaque VM déployée dispose d’un agent Charon pour être pilotée.

Le serveur X-Ray est responsable de maintenir la liste des configurations (configuration de l’infrastructure destination) et également de tous les mots de passes enregistrés (encyptés). Il s’assure qu’une seule série de tests est lancée à la fois. Il collecte l’intégralité des résultats des tests et l’analyse et permet de créer des rapport qui sont également disponibles dans l’UI.

- X-Ray Architecture

- X-Ray reports

Pour approfondir : lien communauté Nutanix / lien officiel Nutanix

Calm

Calm est une nouvelle fonctionnalité de Prism Central qui sera introduite très prochainement. Cet outil n’est cependant pas nouveau car Nutanix a fait l’acquisition de la société CalmIO l’année dernière et a travaillé pour l’intégrer parfaitement dans l’interface Prism sans perdre l’interface Calm qui était très agréable à l’époque.

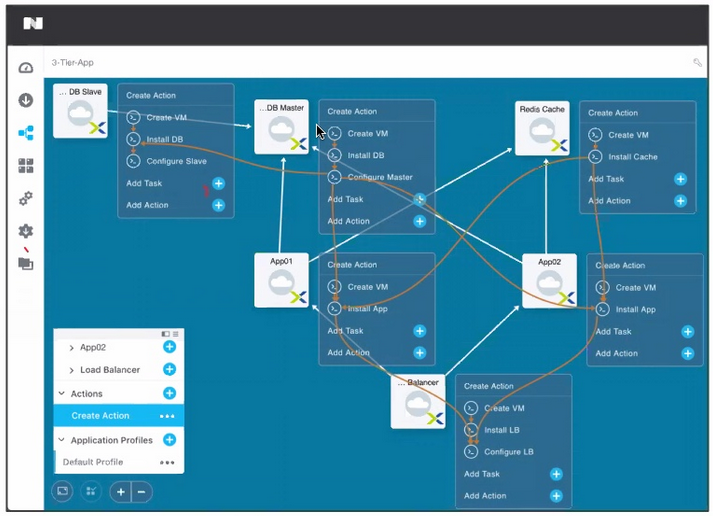

Calm sera le prochain outil d’automatisation, d’orchestration et de gestion du lifecycle d’une application géré directement via l’interface Prism (Central). Il permet de créer des “blueprints” qui contiennent de nombreux composants pour créer, manager un workload entier en minimisant le besoin d’écrire du code supplémentaire. L’exemple ci-dessous de 3-Tier-App montre un exemple de blueprint avec toutes les interactions chaînées entre les composants (flèches oranges), et l’utilisation de variables vous permettra de créer quelque chose de réutilisable sur-demande.

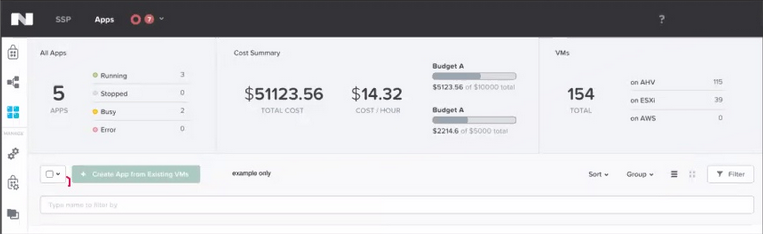

Calm vous permet de déployer ces “blueprints” sur des infrastructures diverses (Nutanix AHV / vSphere / Amazon / Azure…) et de vous faire le chargeback associé (que ce soit on-premise ou cloud public). Ainsi, vous aurez la possibilité de gérer les coûts des projets au sein de votre infrastructure facilement.

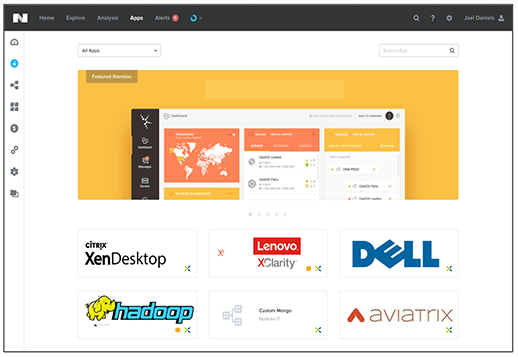

La nouveauté apporté au NEXT 2017 est l’apparition d’un nouveau Marketplace ! Une fière allure d’App Store ou Play Store qui permet de déployer des blueprints Calm préconfigurés par Nutanix (il y aura la possibilité de cloner ces built-in blueprint pour les modifier). Calm s’occupera de toute l’orchestration en tâche de fond pour vous mettre à disposition l’application choisie. De nombreuses applications sont attendues sur le Marketplace comme des outils de backup, services réseaux, serveurs BDD…

Difficile d’être clair tout en montrant l’intégralité des fonctionnalités de Calm, voici une petite vidéo Youtube qui résume bien l’univers Calm. Pour aller plus loin, voici également une vidéo intéressante sur Calm (avant l’intégration dans Prism Central) : lien voir vers 5:52. Lien officiel du produit : lien.

Veeam

Voici une annonce que de nombreuses personnes (y compris moi) attendaient patiemment, sans réellement y croire. Et pourtant, le support de AHV pour VEEAM a été officialisé sans avoir la moindre information supplémentaire. Nutanix ayant développé son propre CBT (Change Block Tracking), il ne reste plus qu’à gérer l’interaction avec PRISM pour accéder aux VM hébergées sur Nutanix AHV.

Mais comment VEEAM va gérer le mode de backup (Hot-add, NBD, NFS) ? Toutes les fonctionnalités seront-elles disponibles ? Est-ce qu’un Storage Integration sera ajouté pour les licences Entreprise Plus ? Beaucoup de questions et peu d’informations, il faut attendre maintenant 🙂

Autres

Sans faire un point supplémentaire, juste vous dire également que HPE va être supporté pour installé Nutanix au Q4 2017 sur des Proliant…

Egalement, apparition des clusters One-node et Two-nodes sans vraiment en savoir plus, cette nouvelles risque toutefois de ravir les entreprises avec des sites ROBO qui ne pouvaient s’offrir le luxe d’avoir un cluster 3 noeuds. Affaire à suivre 🙂